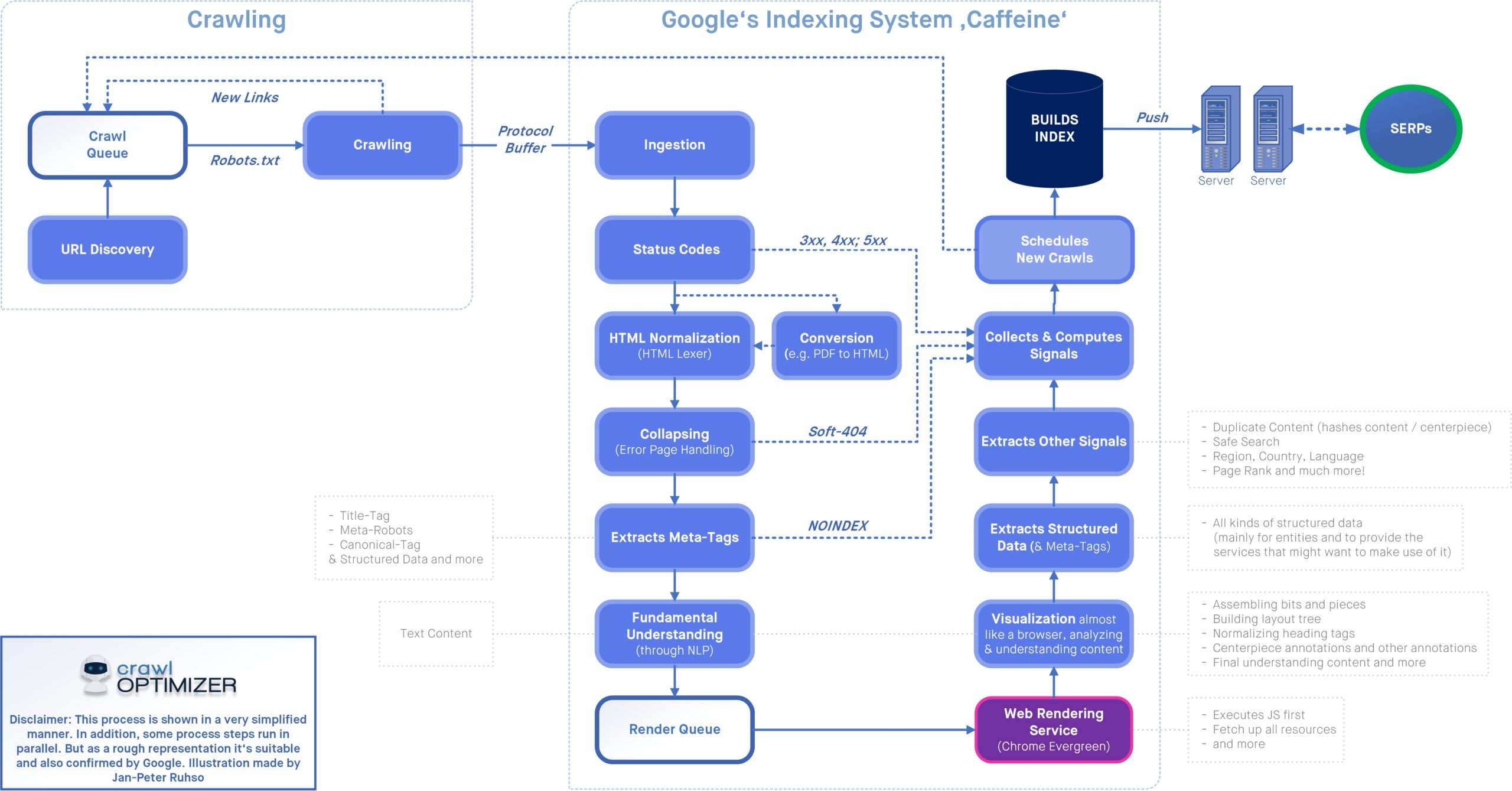

Das (kontinuierliche) Crawling von Webseiten ist ein notwendiger Prozess, damit aktuelle Inhalte und funktionierende Seiten in den Suchergebnissen von Google & Co zur Verfügung stehen. Ob nach der Veröffentlichung eines neuen Inhalts, oder der Aktualisierung einer Seite: nur ein zeitnahes Crawling stellt sicher, dass Google die jeweils aktuellsten Inhalte kennt.

Sogenannte Logfileanalysen sind vor allem etwas für große Seiten mit mehreren 100.000 URLs, da es hier zu Crawling-Ineffizienzen kommen kann, die man über die robots.txt steuern kann.

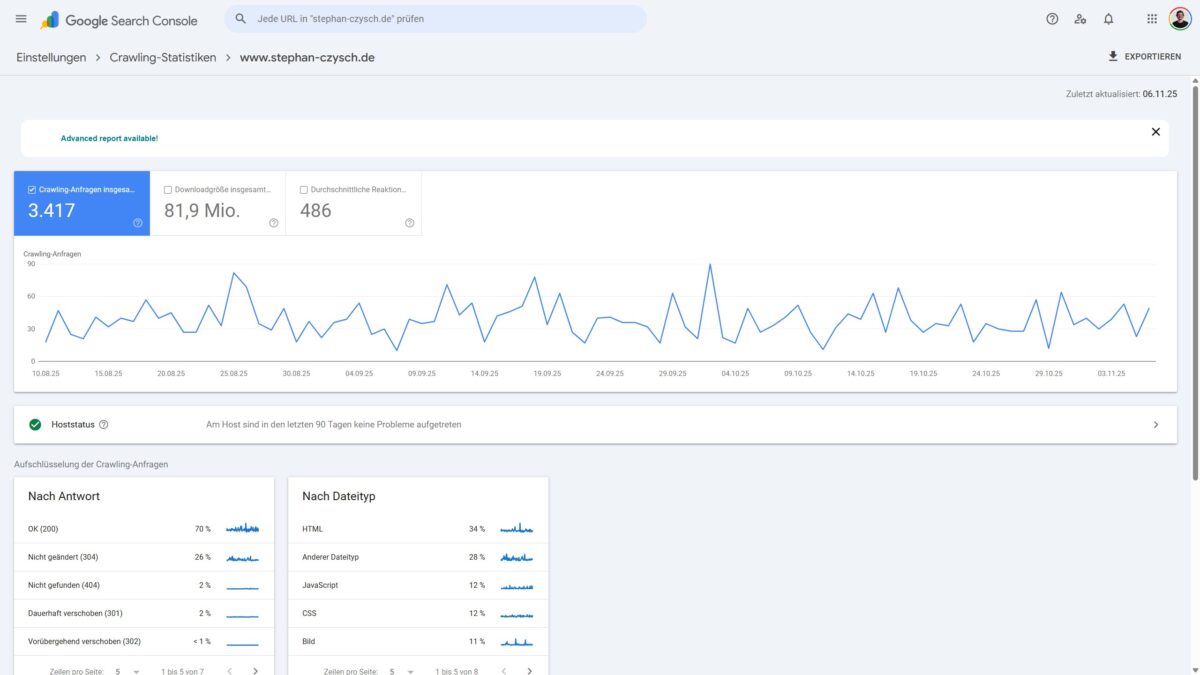

Wer Einblicke in das Crawling-Verhalten des Googlebot sucht, der hat zwei Möglichkeiten: Einmal die Auswertung der eigenen Server-Logfiles, oder die Nutzung der Crawling-Statistiken der Google Search Console.

Beide Methoden haben Vor- und Nachteile:

- Die Beispieldaten in der Google Search Console stehen ohne Aufwand zur Verfügung, sind allerdings unvollständig

- In den Logfiles sind alle Daten enthalten, doch diese müssen gefiltert und bereinigt werden (um „Fake-Googlebots“ auszuklammern), und sind nicht direkt verfügbar

Selbst für viele große Websites ist es komplett ausreichend, über die Google Search Console Daten einen ersten Einblick in das Crawling-Verhalten des Googlebots zu bekommen. Erst wenn hier Auffälligkeiten zu sehen sind, lohnt sich eine detaillierte Logfileanalyse.

Nachteile der Crawling-Daten in der Google Search Console

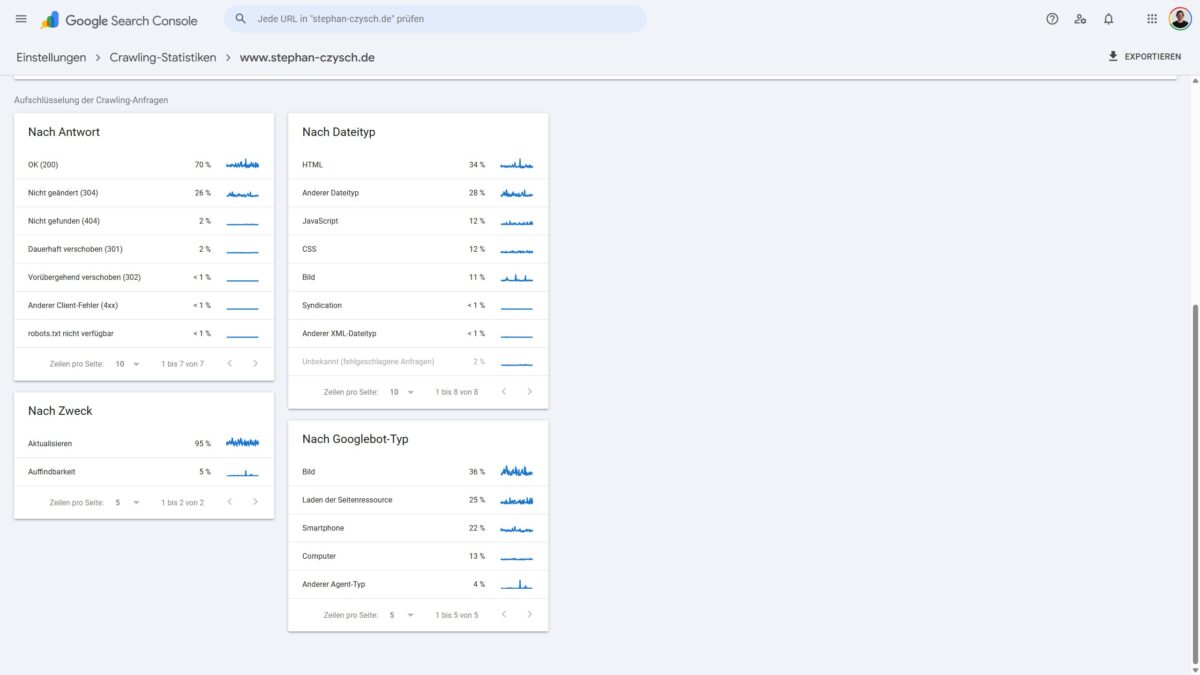

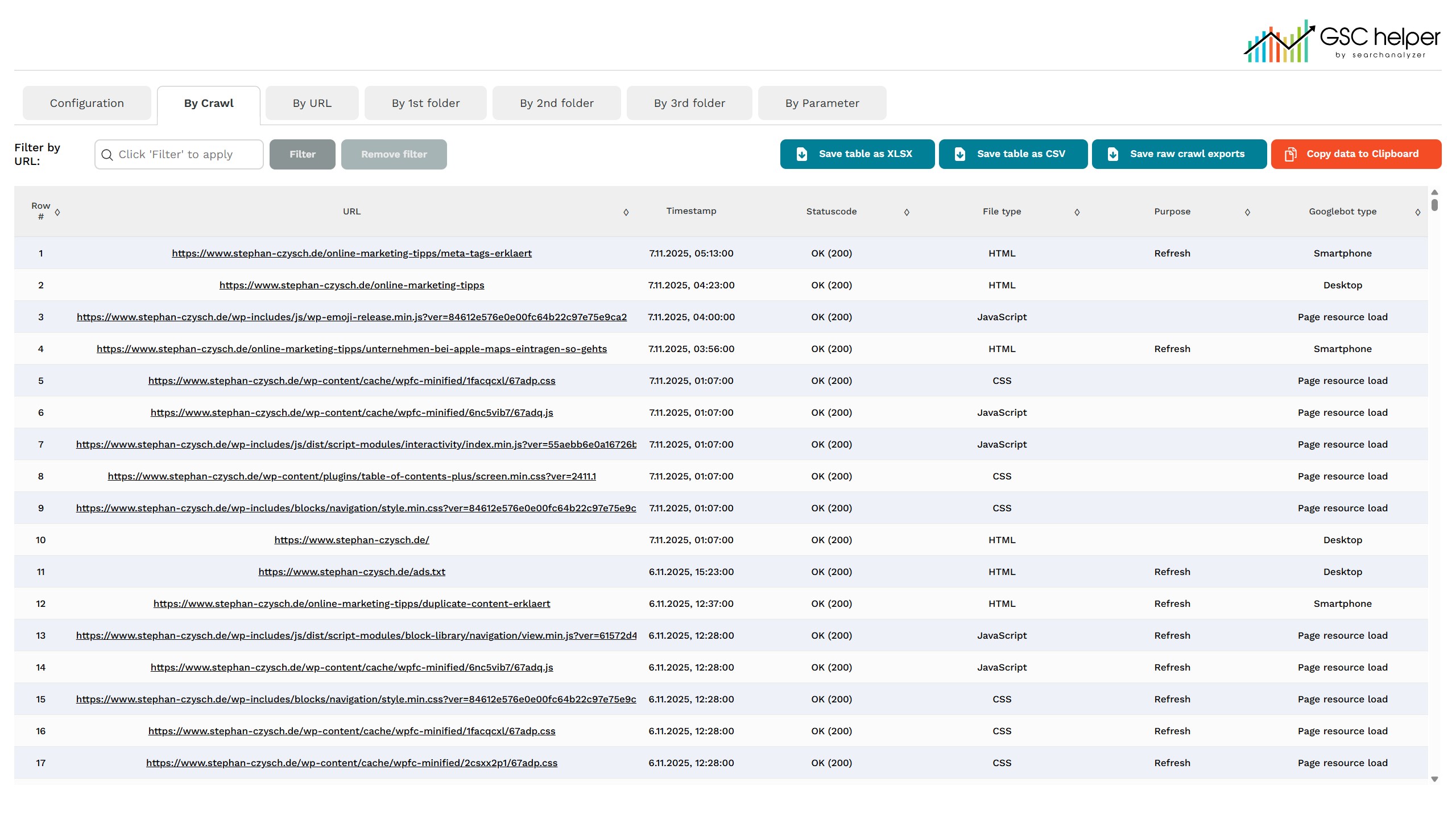

Google liefert bekanntermaßen nur bis zu 1.000 Beispieldatenpunkte in jedem einzelnen Bericht, weshalb nur ein Ausschnitt des Crawlingverhaltens sichtbar wird. Doch da Google mehrere Berichte gruppiert nach

- Antwort

- Dateityp

- Zweck

- Googlebot-Typ

anbietet, lassen sich durch Kombination der Daten mehr als 1.000 Beispielcrawls auswerten.

Welche Subberichte zur Verfügung stehen, ist von Website zu Website unterschiedlich. So ist z.B. der Bericht nach Statuscode „Nicht geändert (304)“ nur dann verfügbar, wenn es gecrawlte URLs gibt, die diesen Statuscode liefern. Eine Auflistung der möglichen Teilberichte gibt es in der Google-Hilfe.

Leider zeigt Google in den einzelnen Berichten immer nur dieselben Datenpunkte an.

- Den Zeitstempel

- Die URL

- Den Statuscode

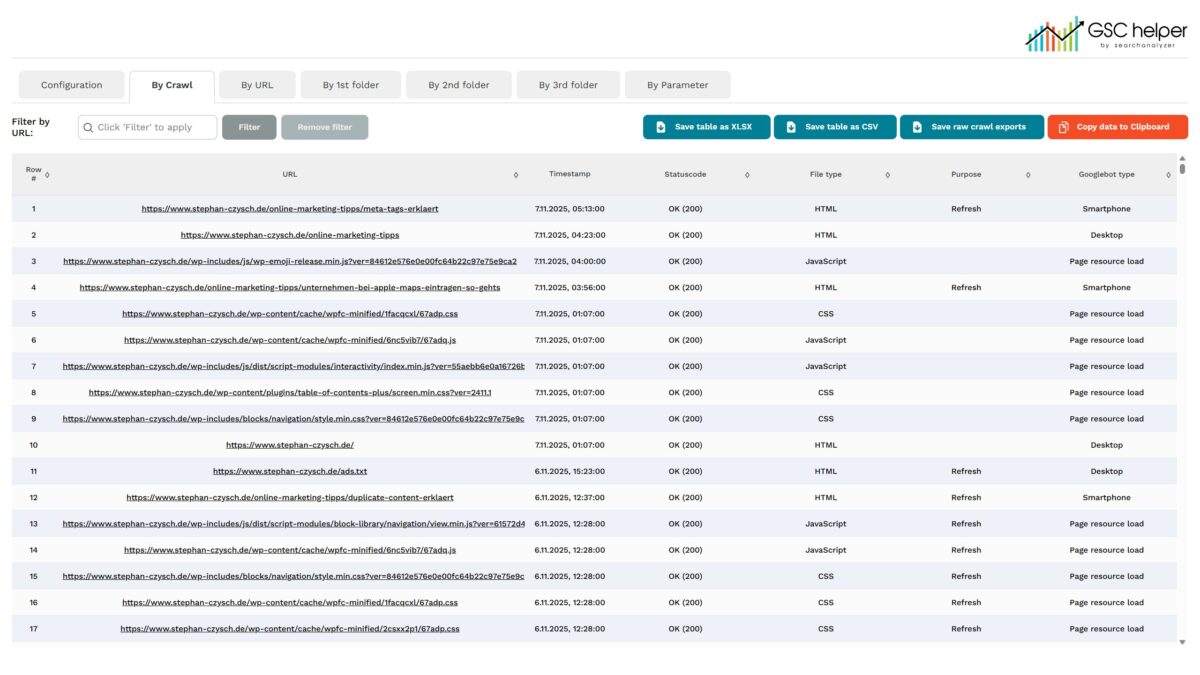

wichtig ist aber häufig die Kombination: Welcher Googlebot hat zu welchem Zweck einen Crawl durchgeführt? Diese Kombination bietet die Google Search Console nicht selbst an – aber meine kostenfreie Google Chrome-Extension „GSC Helper„.

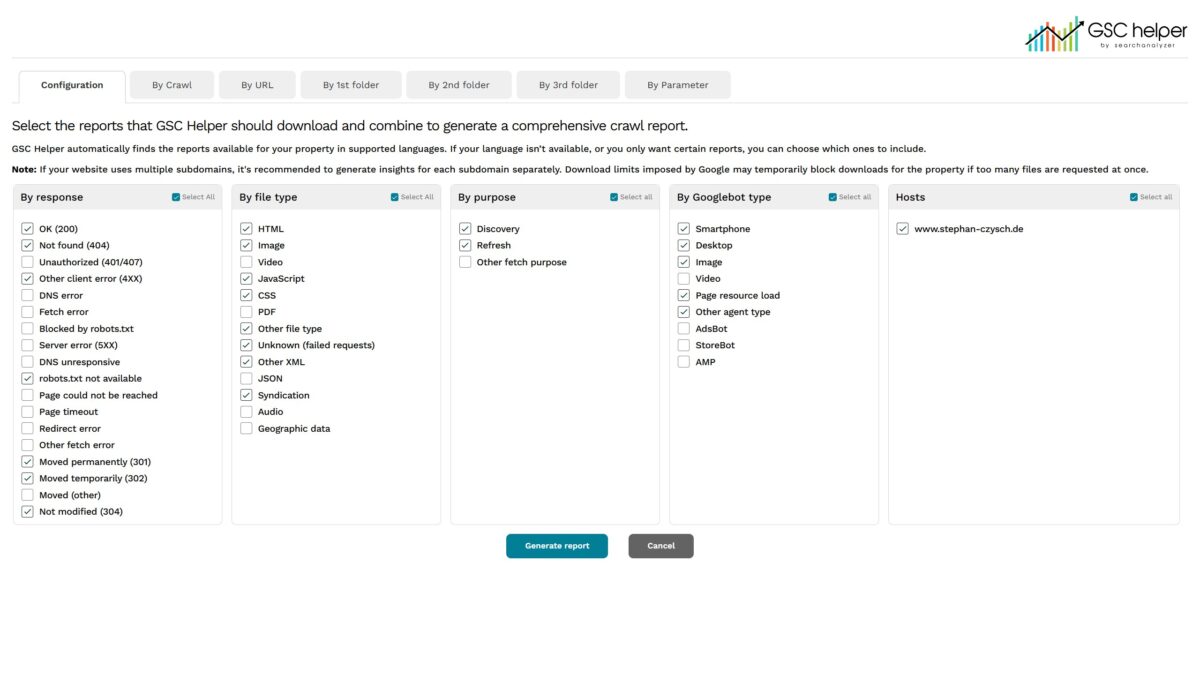

Logfileanalyse mit GSC Helper

Auf der Konfigurationsmaske sind alle verfügbaren Berichte vorausgewählt und können automatisch abgerufen und miteinander kombiniert werden. Dadurch lassen sich für viele Crawls alle von Google gelieferten Datenpunkte kombinieren!

Bei meiner Website waren es in der Summe 3.013 einzelne Crawls, die dank der Kombination der einzelnen Berichte auswertbar sind.

Mehr Information zum Plugin gibt es hier auf searchanalyzer.io. Die Extension kannst du dir direkt aus dem Chrome-Webstore zu deinem Chrome-Browser hinzufügen.

Schreibe einen Kommentar